爬虫的流程:

在开始学习爬虫,我们必须了解爬虫的流程框架。在我看来爬虫的流程大概就是三步,即不论我们爬取的是什么数据,总是可以把爬虫的流程归纳总结为这三步:

- 指定 url, 可以简单的理解为指定要爬取的网址

- 发送请求。requests 模块的请求一般为 get 和 post

- 将爬取的数据存储

requests 模块的下载导入:

因为 requests 模块属于外部库,所以需要我们自己导入库

导入的步骤:

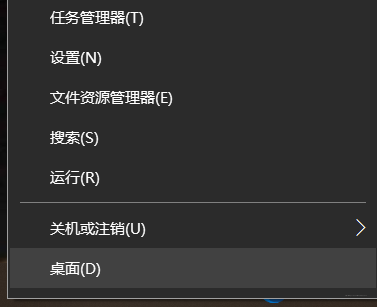

- 右键Windows图标

- 点击“运行”

- 输入“cmd”打开命令面板

- 输入“pip install requests”,等待下载完成

如图:

如果还是下载失败,我的建议是”百度一下,你就知道“(我也是边学边写,是在是水平有限)

欧克,既然导入成功后我们就简单的来爬取一下搜狗的首页吧!

代码如下:

import requests

if __name__ == "__main__":

# 指定url

url = "https://www.sougou.com/"

# 发起请求

# get方法会返回一个响应数据

response = requests.get(url)

# 获取响应数据

page_txt = response.text # text返回一个字符串的响应数据

# print(page_txt)

# 存储

with open("./sougou.html", "w", encoding = "utf-8") as fp:

fp.write(page_txt)

print("爬取数据结束!!!")

我们打开保存的文件,如图